引入cross-entropy代价函数

问:为什么说C是一个代价函数?

问:为什么cross-entropy代价函数能解决"learning slow down"的问题?

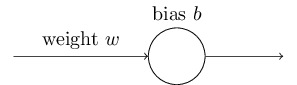

使用cross-entropy作为代价函数对一个神经元的效果。

将cross-entropy应用到整个神经网络

交叉熵代价函数 VS 二次代价函数

Last updated